据国外媒体报道,facebook内部工程项目具有良好声誉——无论是简单地优化信息流算法还是用于分布在全球范围的数据中心硬件。它一直在宣扬其对开放源代码社区的贡献。

facebook上周宣布计划使其人工智能硬件“开源化”。facebook工程师凯文·李(kevin lee)和舍坎·皮安蒂诺(serkan piantino)周四在博文中强调,与市场上的成品相比,开源化的人工智能硬件更高效和通用性更好,因为服务器能在基于开放计算项目标准的数据中心内运行。

凯文·李和皮安蒂诺解释说,“尽管许多高性能计算系统要求专用冷却和其他专用基础设施才能运行,我们针对发热和能源效率对这些新服务器进行了优化,使它们能在我们采用空气冷却、基于开放计算标准的数据中心内运行。”

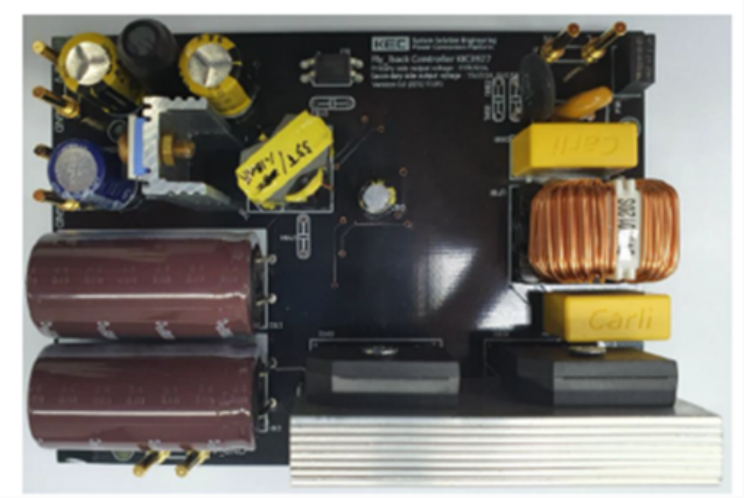

代号为“big sur”的新一代硬件的设计目标是训练神经网络。除人工智能外,这一技术还经常被称作机器或深度学习。

过去一年,芯片厂商英伟达一直在开发深度学习产品。因此,两家公司在这一项目上进行了合作。facebook被称作是第一家采用英伟达tesla m40 gpu加速器的厂商,m40 gpu面向深度神经网络,被认为是big sur平台和open rack兼容硬件的关键。

facebook工程师称,采用m40的big sur平台的速度是该公司上一代产品的2倍,使得训练规模相当于原来2倍的神经网络的速度提高1倍。http://deyie.51dzw.com/

英伟达还强调,big sur是第一款针对机器学习、人工智能研究开发的开放源代码计算系统,facebook将把设计材料提交给开放计算项目。

为了将机器学习技术用于更多产品,人工智能研究团队将把gpu硬件投资增加逾2倍,facebook将充分利用big sur平台。